Previsão de Stephen Hawking sobre inteligência artificial está cada vez mais perto da realidade

16 novembro 2025 às 17h49

COMPARTILHAR

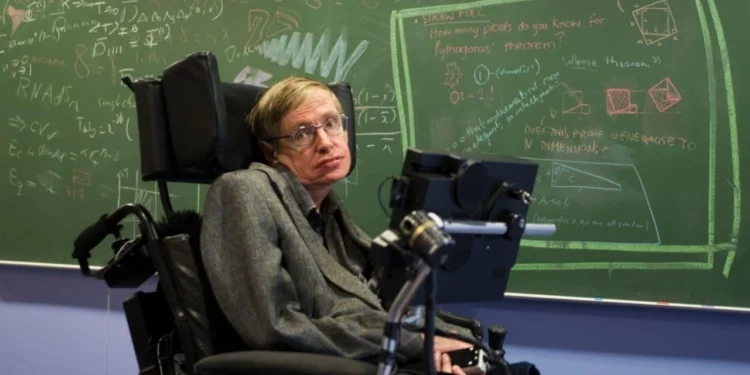

Em meio a discussões sobre os rumos da tecnologia, a previsão de que sistemas de inteligência artificial alcancem níveis de autonomia e capacidade superiores aos humanos, feita pelo físico britânico Stephen Hawking em 2014, está mais atual do que nunca.

À época, muitos enxergaram suas declarações como um cenário distante e exagerado; no entanto, diante da escalada tecnológica atual, tais advertências voltam acompanhadas de análises mais robustas sobre riscos sociais, econômicos e existenciais.

Apesar de o tema ter sido inicialmente recebido com certo ceticismo, as frases proferidas pelo físico continuam ecoando. Em entrevista à BBC, Hawking afirmou: “O desenvolvimento total da inteligência artificial pode significar o fim da raça humana”.

O posicionamento não se baseava em previsões apocalípticas, mas na observação de que máquinas capazes de se auto-aperfeiçoar poderiam evoluir em um ritmo inalcançável para o cérebro humano, ainda preso aos limites da evolução biológica. Assim, ele apontava que o problema não estaria na hostilidade das máquinas, e sim no desequilíbrio de poder que emergiria de sua competência superior.

Ainda em 2014, enquanto sistemas de IA operavam de modo relativamente restrito e dependiam fortemente de comandos humanos, Hawking já chamava atenção para o perigo de uma autonomia crescente. Ele alertava que, se uma máquina se tornasse apta a redesenhar seu próprio software e aprimorar sua estrutura sem intervenção humana, “estaríamos diante de uma situação inédita – e frágil”.

Hoje, com a expansão vertiginosa das arquiteturas de deep learning e com modelos treinados em escalas colossais, a distância entre aquela previsão e a realidade vem diminuindo gradualmente.

Além das preocupações existenciais, Hawking destacava os efeitos sociais e econômicos da chamada “superinteligência”. Para ele, a automação em massa poderia provocar transformações profundas no mercado de trabalho, afetando desde funções operacionais até postos considerados altamente especializados.

À medida que sistemas inteligentes substituíssem trabalhadores, haveria uma concentração significativa de poder nas mãos de quem controla a tecnologia, ampliando desigualdades estruturais. Segundo o físico, esse avanço “poderia deixar a humanidade em estado vulnerável”, não por um ataque de máquinas, mas pela incapacidade de acompanhar o ritmo de mudanças provocadas por elas.

Enquanto isso, pesquisadores contemporâneos reforçam que o cenário de risco não se resume a suposições teóricas. Pelo contrário, depende de três fatores frequentemente mencionados por quem estuda segurança em IA.

O primeiro é o surgimento de sistemas capazes de se auto-aperfeiçoar de forma recursiva, ampliando sua inteligência sem limites claros. Em segundo lugar, há a preocupação com a falta de alinhamento entre objetivos dessas máquinas e valores humanos, o que poderia gerar consequências imprevisíveis mesmo sem intenções maliciosas.

E, por fim, a inexistência de mecanismos de supervisão que garantam que tais modelos permaneçam sob controle humano direto.

Nesse contexto, especialistas argumentam que ignorar essas possibilidades seria reproduzir o “erro” apontado por Hawking: tratar riscos reais como mera ficção científica.

Leia também:

Goiânia divulga calendário escolar de 2026 com início em 20 de janeiro na Rede Municipal

Enem: Mais de 160 mil candidatos em Goiás participam do segundo dia de provas